Наприкінці 2020 року Facebook підтримала державну цензуру у Вʼєтнамі. Комуністична партія Вʼєтнаму — правляча та єдина реальна партія країни. Перед зʼїздом партії, який відбувся в січні 2021 року, керівництво Вʼєтнаму вимагало, щоб Facebook жорсткіше модерувала контент вʼєтнамських користувачів з антиурядовим ухилом — видаляла пости та коментарі. І соцмережа погодилася, аби не втрачати ринок, який щороку приносить їй близько мільярда доларів. На запитання журналістів керівництво Facebook відповіло, що погодилося виконати вимоги вʼєтнамської влади, аби їхні послуги «залишалися доступними для мільйонів людей, які покладаються на них щодня».

Алгоритми Facebook залучають людей до теорій змови та конспірологічних груп. У 2019 році сама компанія провела дослідження роботи алгоритмів. Для цього створили кілька фейкових облікових записів, наприклад вигаданої Керол Сміт — консервативної домогосподарки з Північної Кароліни, яка дивиться Fox News і підтримує Дональда Трампа. Акаунт Сміт ніколи не вступав до груп, присвячених теорії змови, але соцмережа сама почала активно пропонувати «місіс Сміт» вступити до групи QAnon. І навіть коли обліковий запис відмовлявся вступати в ці групи, платформа все одно пропонувала різний конспірологічний контент.

Інший тестовий обліковий запис вигаданої людини з Індії, навпаки, вступав у всі групи, які рекомендувала платформа. І дуже швидко опинився серед найрізноманітніших екстремістських, расистських, антинаукових груп і жорстокого шок-контенту.

«У стрічці новин цього тестового користувача я за три тижні бачив більше зображень мертвих людей, аніж за все своє життя», — говорить дослідник, який вів акаунт.

Facebook не пропонує користувачам контент на вибір, а заганяє їх у вузькі «кролячі нори», постійно пропонуючи їм одне й те саме. Аж до небезпечних сект і екстремістів. Компанія не розголошувала це дослідження, але воно потрапило до Facebook Papers.

Френсіс Хауген (ліворуч) залишає будівлю парламенту в Лондоні після того, як свідчила в рамках планів уряду щодо регулювання соціальних мереж, 25 жовтня 2021 року.

Getty Images

Молодь іде з Facebook, але компанія приховує це від інвесторів і рекламодавців. Молодь все рідше реєструється у Facebook і проводить там дедалі менше часу. Наприклад, згідно зі звітом, що потрапив у Facebook Papers, час, проведений підлітками зі США в соцмережі, скоротився на 16 відсотків, як порівняти з минулим роком. А у 2018 році 11 відсотків підліткових облікових записів були дублюючими, тобто належали людям, у яких обліковий запис вже був.

Але керівництво платформи приховує цей факт, надаючи інвесторам і великим рекламодавцям лише загальну статистику. Зокрема, штучно завищує кількість акаунтів, коли зараховує дублюючі облікові записи як акаунти різних людей. З дублюючими аккаунтами — SUMA — у компанії майже ніяк не боролися, хоча обіцяли партнерам з цим розібратися. У Facebook вже заявили, що повідомлять рекламодавців про ризик потрапляння покупок в акаунти, що дублюються, але все це — випадкові помилки.

Facebook заохочувала емоційний, провокаційний та шокуючий контент. У 2016 році соцмережа доповнила звичний лайк різними реакціями-емодзі. При цьому емоційні реакції «важили» більше за простий лайк. Наприклад, реакцію «обурливо» платформа рахувала відразу за пʼять лайків. Відповідно, контент, який викликав щире обурення користувачів, частіше потрапляв у стрічку і був вигіднішим. Уже тоді співробітники компанії критикували це рішення, вважаючи, що воно відкриває шлях до спаму і клікбейту. У 2020 році «вагу» реакції «обурливо» обнулили, а реакції «люблю» та «співчуваю» тепер дорівнюють двом лайкам.

У деяких країнах Facebook модерує контент добре, а в деяких — погано. У деяких — не модерує взагалі. Так, 84 відсотки бюджету та ресурсів, виділених на модерацію контенту, йшло на роботу з користувачами зі США. Хоча це лише 10 відсотків від усіх користувачів платформи. Водночас деяким країнам не вистачає модераторів, через що відбувається плутанина, коли користувачів банять за екстремізм, неправильно перекладаючи фрази з арабської. У третіх країнах модерації практично немає — у Мʼянмі, наприклад, соцмережа є інформаційним хаосом.

Проблема — у нерівномірному розподілі ресурсів. Побоюючись судових позовів, компанія надмірно контролює контент у демократичних країнах і зовсім не контролює там, де хейтспіч у мережі може легко спричинити сплески насильства.

Строго кажучи, компанія взагалі не може модерувати весь контент. Зараз у Facebook працюють приблизно 15 тисяч модераторів, які говорять 70 мовами, щоправда, багато хто — лише англійською. Контент ще 40 мовами та незліченною кількістю діалектів у принципі залишається поза всякою модерацією.

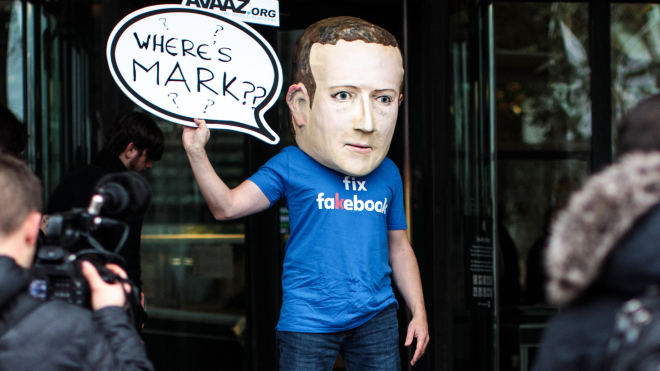

Залишається під сумнівом особиста причетність Марка Цукерберга до цих історій. Його підписи рідко зʼявлялися під документами, звітами та резолюціями, але колишні співробітники стверджують, що Цукерберг опікувався майже всіма аспектами роботи компанії.

«Привид Цукерберга вимальовується в усьому, що робить компанія», — сказав Браян Боланд, колишній віцепрезидент Facebook з партнерських звʼязків і маркетингу. Він пішов у 2020 році, після того як дійшов висновку, що платформа поляризує суспільство.

Діяльність Цукерберга розслідуватиме Комісія з цінних паперів і бірж США. Позиція її нинішнього керівника Гері Генслера поки невідома, але колишній керівник відділення SEC із викриття правопорушень Шон МакКессі вважає, що зняти з себе відповідальність засновнику Facebook не вдасться: «Цукерберг має бути рушійною силою цих рішень. [Facebook] це не типова публічна компанія із системою стримування і противаг. Це не демократія, це авторитарна держава».

Марк Цукерберг, генеральний директор і засновник Facebook Inc., очікує на початок спільних слухань судового та комерційного комітетів Сенату у Вашингтоні, округ Колумбія, США, 10 квітня 2018 року.

Getty Images

Ми не віримо в теорії змови, але віримо в журналістику, яка справді дозволяє дізнатися правду. Підтримайте «Бабель» донатом.